Автор Оксана Полулях

Сегодня практически каждый человек имеет доступ к инструментам искусственного интеллекта (ИИ), способным создавать реалистично выглядящие изображения – по крайней мере, на первый взгляд. Однако эти технологии становятся мощным инструментом в руках тех, кто стремится манипулировать общественным мнением. Россия активно использует ИИ в своей информационной войне. Как работают ИИ-фальшивки, почему они особенно опасны во время войны и как их распознать – в этом материале.

Способны ли мы распознать ИИ сгенерированные изображения?

Согласно исследованию Чикагского университета, только 60% интернет-пользователей могут определить, создано ли изображение с помощью ИИ. Это вызывает беспокойство, учитывая постоянное усовершенствование таких технологий. Украинцы также не исключение. Опрос Kantar Украина (февраль 2024) показал, что 79% респондентов знают, что такое ИИ, но только 42% уверены в своих навыках распознавать подобный контент.

Неумение отличить реальное от сгенерированного имеет важные последствия: от нарушения авторских прав до рисков дезинформации и мошенничества.

Почему сгенерированный ИИ контент может быть опасен?

ИИ-изображения часто используются для манипулирования эмоциями. Вы, наверное, встречали в своей Facebook-ленте изображения якобы военных с просьбой поддержать их в важные моменты – день рождения или бракосочетания. Вам же не сложно поставить лайк военному, который только что женился? И может, стоит поддержать комментарием юношу, которого никто из родных не поздравил с днем рождения?

Коллаж – StopFake

Такие публикации собирают тысячи предпочтений и комментариев, повышая охват страниц. Однако за их эмоциональностью могут скрываться злонамеренные планы: страницы меняют тематику или используются для распространения пропаганды.

С проблемой распространения ИИ-сгенерированного контента сталкиваются не только украинские соцсети. Американский Facebook также наводнили подобные изображения: пожилых людей, людей с ампутированными конечностями и младенцев. Такие публикации часто сопровождаются публикациями типа «Никто никогда не благословлял меня» или «Сделал это своими руками. Буду рад вашим оценкам». В августе 2024 года Рене ДиРеста из Стэнфордского университета и Джош Голдштейн из Центра безопасности и новых технологий Джорджтаунского университета опубликовали исследование, которое показало, что ИИ-сгенерированные изображения активно используются мошенниками и спамерами. Такие изображения способствуют быстрому росту аудитории страниц и повышают активность пользователей, что позволяет впоследствии монетизировать их популярность. Как следствие, эти страницы часто меняют названия и начинают распространять совсем другой контент, иногда мошеннического характера.

Кроме переименований страниц, мошенники манипулируют и содержанием публикаций. Например, вчера вы могли поделиться изображением военного, призывающего молиться за победу, а сегодня обнаружить на его месте совсем другой пост с противоположным содержанием. Такая тактика вводит пользователей в заблуждение, создавая иллюзию широкой поддержки новой публикации, хотя «лайки» и «репосты» были получены благодаря другому контенту. StopFake исследовал подобный случай: злоумышленники отредактировали содержание публикации, превратив ее в фейк, описанный в материале «Фейк: Украинский пилот украл самолет и «сбежал в Африку к любимой».

Аналитики Института массовой информации обнаружили, что религиозная организация, основанная в Китае, использует ИИ-сгенерированные изображения для привлечения украинцев в свои ряды. Под эмоциональными фотографиями украинских военных или пожилых людей, на которые пользователи реагируют лайками, содержатся приглашения в закрытые группы в WhatsApp для совместных молитв. Однако, на этих онлайн-собраниях, вместо обещанных молитв за украинских воинов, распространяются нарративы, толерантные к прославлению страны-агрессора россии. Эксперты ИМИ подчеркивают, что такие методы направлены на уязвимых людей, в том числе тех, в чьих семьях есть военные. Эти люди часто переживают за дальнейший ход войны и ищут поддержку.

Скриншот – ІМІ

В условиях войны подобные действия выглядят особенно угрожающими. В Центре противодействия дезинформации при СНБО отмечают, что страницы с ИИ-генерируемыми изображениями собирают большую аудиторию, которая недостаточно критично относится к информации в сети и восприимчива к информационным манипуляциям. Таким образом, враг получает площадку для продвижения опасных для Украины нарративов.

В октябре 2024 года корпорация Microsoft обнародовала отчет о киберугрозах, охватывающий период с июля 2023 по июнь 2024 года. Согласно отчету, такие страны, как Россия, Иран и Китай все активнее используют ИИ для повышения охвата, эффективности и привлечения в своих информационных кампаниях. Даже разработчики ИИ-инструментов признают: их инструменты, как ChatGPT, неконтролируемо используются россией для манипулирования общественным мнением по всему миру.

Одним из наиболее заметных примеров информационной атаки россии против Украины стал шквал ИИ-сгенерированных изображений украинских военных, распространявшийся в конце 2023 года. Эти изображения сопровождались текстами о том, что украинские военные в Авдеевке Донецкой области молятся о спасении и просят о молитве украинцев. Учитывая сложность боев в этом регионе, такие сообщения оказали сильное эмоциональное влияние.

Однако, по наблюдениям StopFake, основными распространителями этих публикаций были ботообразные аккаунты. Масштаб и быстрота распространения контента указывают на то, что эта кампания была тщательно спланированной частью российской дезинформационной операции. Ее главная цель – посеять среди украинцев чувство страха, паники и уныния, а также подорвать боевой дух защитников.

Данная кампания также демонстрирует, как эффективно используются ИИ технологии для создания иллюзии масштабной поддержки или паники. Некоторые изображения военных в моменты отчаяния выглядели настолько реалистично, что могли сбить с толку даже опытных пользователей сети. Кроме подрыва морального состояния, такие манипуляции направлены на усиление внутренних противоречий в обществе, распространение сомнений в стратегии обороны Украины и на создание образа «уставшей» армии.

Коллаж – StopFake

На этой фотографии изображен малыш, якобы выживший после очередного российского обстрела Днипра. Подпись к фото эмоционально подчеркивает трагедию: «Он навсегда запомнит, кто разрушил его мир». Мальчик стоит на фоне разрушенного здания, держа в руках, вероятно, кусочек хлеба. Шеврон с флагом на его куртке недвусмысленно указывает на то, что он украинец. Несмотря на явные признаки того, что это изображение не настоящее, многие пользователи в комментариях искренне сочувствовали ребенку, интересуясь судьбой его родителей.

Скриншот – facebook.com

Это изображение стало вирусным 14 января 2023 года, вскоре после ракетного удара по многоэтажке в Днипре, который забрал жизни 46 человек, в том числе шестерых детей, и оставил около 80 раненых. Даже официальные аккаунты Верховной Рады Украины распространили данный контент, что вызвало шквал возмущения и критики, ведь использование ИИ-сгенерированных изображений в подобном контексте лишь подрывает доверие к реальным фактам.

Такие ИИ-изображения, имитирующие последствия разрушений в Украине и страдания гражданского населения, часто становятся вирусными. Их распространяют даже активнее, чем реальные фотографии последствий российских атак. Некоторые оправдывают это тем, что такие изображения являются лишь «иллюстративными», но статистика доказывает другое: 40% пользователей не могут распознать ИИ-сгенерированные изображения.

Использование таких фото не только размывает реальность, но и искажает правду о военных преступлениях россии. Российская пропаганда использует насыщение информационного пространства подобными материалами для формирования нарратива о том, что жертвы среди гражданского населения в Украине – выдумка украинской и западных разведок. Логика пропаганды проста: если украинцы врут о мальчике из Днипра, они могут солгать и о других трагедиях».

О том, как российская дезинформация создает и распространяет подобные сомнения, можно узнать из материалов StopFake: «Фейк: Массовые жертвы среди мирного населения Киевской области – инсценировка», «Фейк: Зверства российских военных в Гостомеле – «украинское постановочное видео», Видеофейк: репортаж о жертвах среди гражданского населения в Украине – «постановочный».

Такие случаи подчеркивают необходимость критического мышления и проверки информации, ведь неосторожное распространение ИИ-сгенерированного контента может сыграть на руку российской пропаганде.

Как распознать ИИ-сгенерированное изображение?

Выявление поддельных изображений, созданных с помощью искусственного интеллекта, является сложной задачей, но это возможно сделать. Ниже приведены основные подходы и критерии, которые помогут определить, является ли фото реальным либо сгенерированным ИИ.

- Проверка водяных знаков и метаданных

• Водяные знаки. Прежде всего проверьте, содержит ли изображение водяной знак генератора ИИ (например, MidJourney или DALL-E). Водяной знак часто находится в углу изображения.

• Описание изображения. Внимательно просмотрите подписи к публикации или комментарии – автор может назвать первоисточник или указать, что изображение было создано с помощью ИИ.

• Метаданные. Если они доступны, анализ метаданных может предоставить информацию о дате создания, местоположении, настройке камеры и даже инструменте, которым было создано изображение. Анализ метаданных может стать ключевым инструментом для проверки подлинности изображений. Для этого можно использовать такие программы, как ExifTool или Exif Pilot, которые необходимо установить на компьютер. Эти программы обеспечивают детальный анализ метаданных файлов и подходят для работы с разными форматами.

Удобным онлайн-инструментом является metadata2go – сервис, позволяющий быстро проверить метаданные, загрузив файл на сайт.

2. Визуальный анализ изображения

ИИ-сгенерированные фото часто имеют искажения или неестественные детали. Среди основных признаков:

- Фон. Изображения нередко имеют размытый или нечеткий фон. Предметы позади основного сюжета могут быть искаженными – удлиненными, неестественно расположенными или созданными из нескольких частей.

- Освещение. Аномалии в распределении света – неправильное падение теней, странная яркость или освещение, противоречащее законам физики. Например, солнечные лучи могут «забыть» о реалистичном освещении объекта.

- Подробности лица и конечностей. Хотя ИИ почти в совершенстве воспроизводит лицо, все еще случаются ошибки:

— асимметрия лица (неодинаковый размер глаз, неестественное расположение зубов или ушей);

— лишние пальцы, неестественно изогнутые конечности или проблемы с ногтями.

- Мелкие детали и надписи. Часто униформа, камуфляж или шевроны на изображениях созданы с ошибками – они могут быть вымышленными или содержать нереалистичные элементы (например, подсумки, пришитые непосредственно к кителю). Надписи на изображениях обычно состоят из случайных букв, пробелов или выглядят бессмысленно.

- Дублирование и повторение элементов. ИИ часто изображает людей с почти идентичными лицами или дублирует текстуры. К примеру, стены, мебель или другие объекты на фоне могут повторяться.

- Место в пространстве. Смотрите, как детали расположены относительно друг друга. Предметы, такие как очки или украшения, могут «сливаться» с лицом или, наоборот, находиться на расстоянии, где они не должны быть.

- Цифровые артефакты. Обратите внимание на пикселизацию, странные цветные аномалии или размытие в областях, где это выглядит нелогично.

3. Использование специализированных инструментов

Существуют детекторы искусственного интеллекта, позволяющие проверять изображения на предмет их генерации с помощью ИИ. Расскажем подробнее о каждом из популярных инструментов:

Этот инструмент специализируется на анализе изображений и видео для определения возможных манипуляций или ИИ-генерации. Вы можете загрузить изображение на сайт без регистрации и получить быстрый результат. Инструмент удобен для пользователей, нуждающихся в простом и доступном решении.

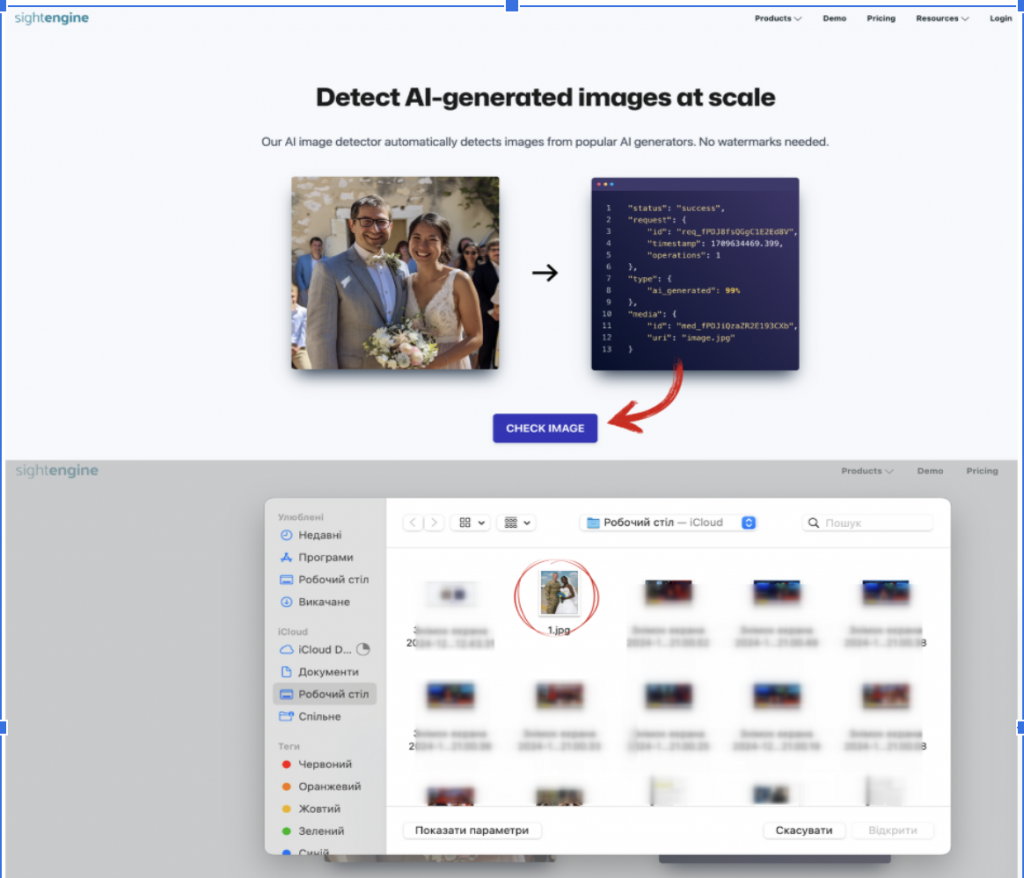

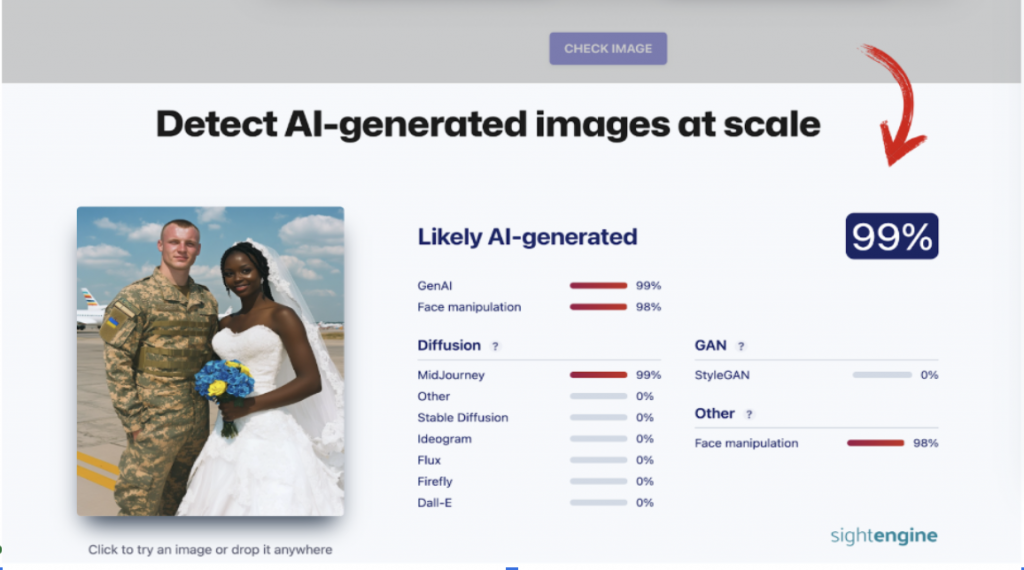

SightEngine – это мощный инструмент, предоставляющий широкий спектр возможностей, включая определение изображений, созданных ИИ, проверку контента на соответствие стандартам и обнаружение манипуляций.

Сервис доступен в бесплатном режиме с ограниченными функциями. Вы можете проверить изображение бесплатно и без регистрации: для этого достаточно перейти в раздел «Detect AI-generated images at scale», загрузить изображение на сайт и дождаться результатов. SightEngine способен определить вероятность того, что изображение создано ИИ, а также указать конкретный генератор (например, MidJourney, DALL-E или Stable Diffusion).

Этот инструмент работает как онлайн-сервис и позволяет быстро определить, было ли изображение создано искусственным интеллектом. Для базового анализа достаточно воспользоваться бесплатной пробной версией, однако для этого необходимо зарегистрироваться на сайте. После регистрации вы можете загрузить изображение, и система предоставит результаты проверки, указывая вероятность генерации ИИ. Бесплатная версия позволяет проверить до 10 изображений.

Инструмент идеально подходит для быстрой проверки изображений, однако без регистрации его использовать невозможно.

Hive Moderation – это инструмент, работающий на основе API, который подходит для автоматической проверки больших объемов изображений. В то же время сервис предлагает бесплатную демоверсию для индивидуальных пользователей. Чтобы воспользоваться им, необходимо зарегистрироваться на сайте.

Однако проверка изображений возможна и без регистрации. Для этого нужно перейти в раздел «AI-generated content detection» и выбрать функцию «See our AI-Generated Content Detection tools in action». Вы можете загрузить изображение и получить базовые результаты проверки, в частности, информацию о возможном использовании генераторов ИИ.

Скриншот – sightengine.com

Каждый из этих инструментов может быть полезен в зависимости от ваших потребностей – от быстрого анализа отдельных изображений до масштабной проверки контента.

Важно: эти инструменты не всегда дают точный результат, особенно если изображения низкого качества, поэтому их следует использовать в качестве дополнительного, а не основного метода проверки. Мы также советуем комбинировать анализ с другими способами верификации для достижения максимальной достоверности.

4. Интерактивное обучение

Для усовершенствования навыков распознавания ИИ-изображений можно использовать интерактивные платформы, такие как тест от The New York Times. Они позволяют тренировать внимательность и улучшать способность идентифицировать подделки.

Искусственный интеллект открывает большие возможности, но в то же время создает риски для информационного пространства, особенно в условиях войны.

ИИ-сгенерированные изображения способны вызывать сильные эмоции, вводить в заблуждение и служить инструментом для дезинформационных кампаний врага.

Важно помнить: любое взаимодействие с подозрительным контентом – лайк, комментарий или репост – может сыграть на руку врагу: способствовать продвижению пропагандистских нарративов, подрывать доверие к реальным фактам и даже может усиливать панику в обществе. Взаимодействие с информацией во время войны требует ответственности. Проверка фактов и сознательное отношение к контенту не только помогут защитить себя, но станут вкладом в устойчивость общества перед информационными угрозами.

Статья подготовлена при поддержке NDI