Przed kilkoma dniami spółka Meta (nowa nazwa firmy będącej właścicielem takich usług jak Facebook, WhatsApp czy Instagram, wcześniej po prostu Facebook) ujawniła nowe narzędzie, które już wykorzystuje w zwalczaniu plagi fałszywych informacji i innych szkodliwych treści na swoich platformach, a przede wszystkim na swoim flagowym portalu społecznościowym.

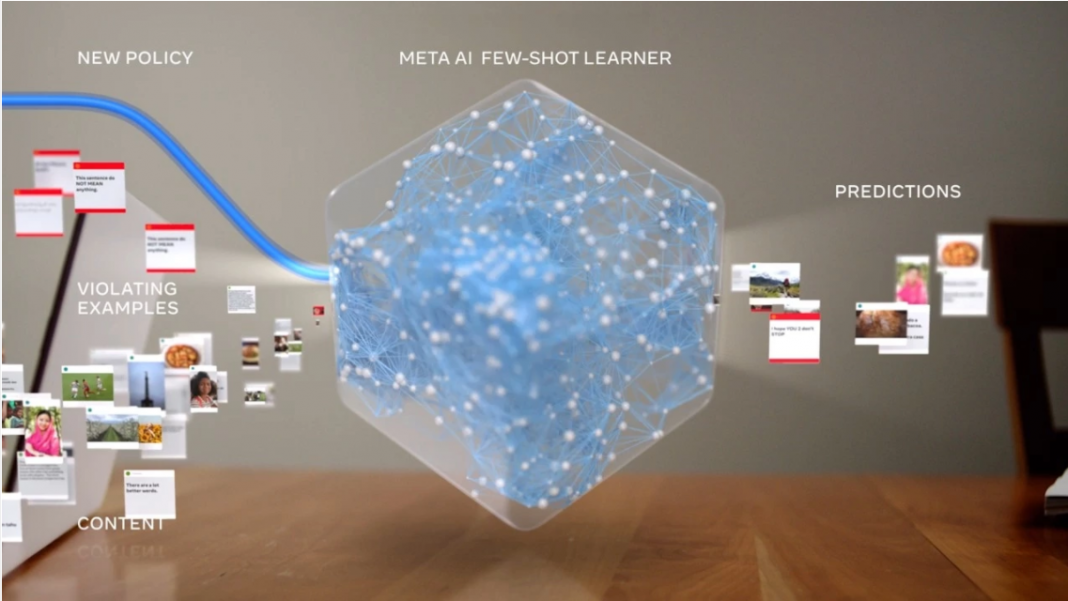

Narzędzie o nazwie Few-Shot Learner jest oparte na samouczącym się algorytmie. W oparciu o istniejące zasady polityki umieszczania treści na portalu Facebook i przykłady ich łamania maszyna uczy się pewnych zwrotów, wyrażeń i schematów. Co więcej, algorytm ma nie tylko rozpoznawać dezinformację podobną do tej już mu znanej, ale dynamicznie uczyć się nowych form bo, jak argumentuje firma Marka Zuckerberga, „szkodliwe treści nieustannie szybko ewoluują – czy to zasilane bieżącymi wydarzeniami, czy z powodu działań ludzi szukających nowych dróg obejścia systemów – i jest kluczowe, żeby systemy sztucznej inteligencji ewoluowały razem z nimi”.

Tutaj Meta napotkała ograniczenia uczenia maszynowego – baza przykładów do nauki musi obejmować dziesiątki, setki tysięcy, a nawet miliony postów. Siłą rzeczy zmniejsza to responsywność i wymusza długi czas przygotowania systemu do nowych działań, liczony nawet w miesiącach. Nowa sztuczna inteligencja od Meta ma ten proces skrócić do tygodni, dzięki wyjściu od zrozumienia tematu od ogółu, potem najwyżej, choć nie obowiązkowo, porównując go z przykładami.

Warto w tym miejscu wyjaśnić podstawy uczenia maszynowego (ang. machine learning). Polega ono na stworzeniu algorytmów, które pozwolą sztucznej inteligencji samodzielnie doskonalić się w oparciu o dostarczane dane. Cechą charakterystyczną jest bardzo szeroki zakres danych wykorzystywanych do nauki. W przypadku algorytmów rozpoznawania obrazów będą to chociażby odpowiednio opisane zdjęcia. Z czasem algorytm nauczy się rozróżniać jabłka od pomarańczy, psy od kotów, ludzi od manekinów. Doskonałe pole do rozwoju tego typu technologii oferuje Internet – algorytmy uczą się na milionach przykładów znalezionych w sieci. Prowadzi to jednak czasem do problemów – znaleźć można doniesienia o co najmniej kilku sztucznych inteligencjach, które, mając symulować prawdziwego użytkownika Internetu, nabierały cech rasistowskich czy seksistowskich.

Zaletą nowego systemu przedstawionego przez Meta ma być fakt, że operuje on w ponad stu językach. Rozpoznaje więc szkodliwe treści nie tylko po angielsku, ale także francusku, hiszpańsku czy rosyjsku. Według zapewnień firmy, ma także radzić sobie z treściami innymi niż tekst, takimi jak zdjęcia czy wideo.

Oczywiście projekt jest w dosyć wczesnym stadium rozwoju. Właściciele Facebooka pokładają w nim jednak duże nadzieje: „wierzymy, że FSL może z czasem zwiększyć efektywność wszystkich naszych systemów sztucznej inteligencji w zakresie integralności, pozwalając im wykorzystać pojedynczą wspólną bazę wiedzy do radzenia sobie z różnymi typami naruszeń. Jest jeszcze wiele pracy do zrobienia, ale te wczesne rezultaty produkcji są istotnym kamieniem milowym, który zaznacza zmianę w stronę bardziej inteligentnych, ogólnych systemów sztucznej inteligencji”.

Zaprezentowany przez Meta system rzeczywiście daje nadzieję na poprawę sytuacji. Mimo deklarowanych od dłuższego czasu działań dezinformacja w mediach społecznościowych wciąż ma się dobrze. Dalsza automatyzacja stwarza jednak obawy o przejrzystość i rzetelność blokowania treści. Już obecnie uzyskanie informacji dlaczego dana treść została zbanowana na Facebooku jest skomplikowane. Dalsze ograniczenie czynnika ludzkiego może sprawić, że w przypadku niesłusznego zablokowania będzie jeszcze trudniej o kontakt i weryfikację. Z drugiej strony jednak rozwój technologii pozwala ufać, że nowoczesne samouczące się algorytmy z czasem poprawią się na tyle, by odróżniać dezinformację od wiadomości prawdziwych – skuteczniej niż niejeden prawdziwy – ludzki – użytkownik.

PMB

Źródła:

Fot. Zrzut ekranu z profilu Meta