Fonte Francesco Marconi

L’intelligenza artificiale sta alimentando la prossima fase della disinformazione. Il nuovo tipo di media sintetici noto come deepfakes pone sfide importanti per le redazioni quando si tratta di verifica. Questo contenuto è davvero difficile da rintracciare: puoi dire quale delle seguenti immagini è un falso?

Al Wall Street Journal prendiamo sul serio questa minaccia e abbiamo lanciato una task force interna di approfondimento guidata dagli Ethics & Standards e dai team di ricerca e sviluppo. Questo gruppo, il Comitato Forense della WSJ Media, è composto da video, foto, grafica, ricerca, piattaforma e redattori di notizie che sono stati addestrati nel rilevamento di Deepfake. Oltre a questo impegno principale, stiamo organizzando seminari di formazione con i giornalisti, sviluppando guide alle notizie e collaborando con istituzioni accademiche come Cornell Tech per identificare i modi in cui la tecnologia può essere utilizzata per combattere questo problema.

“Aumentare la consapevolezza in sala stampa sulle ultime tecnologie è fondamentale”, ha dichiarato Christine Glancey, vice editrice del team di etica e standard che ha guidato la commissione forense. “Non sappiamo dove potrebbero emergere i futuri deepfakes, quindi vogliamo che tutti gli occhi guardino alla disinformazione.”

Ecco una panoramica per i giornalisti sugli approfondimenti che abbiamo acquisito e le pratiche che stiamo utilizzando in merito a deepfakes.

Come vengono creati i deepfakes?

La produzione della maggior parte dei deepfakes si basa su una tecnica di machine learning chiamata “generative adversarial networks” o GAN. Questo approccio può essere utilizzato dai falsari per scambiare i volti di due persone, ad esempio quelle di un politico e di un attore. L’algoritmo cerca istanze in cui entrambe le persone mostrano espressioni simili e il posizionamento facciale. Sullo sfondo gli algoritmi di intelligenza artificiale cercano la migliore corrispondenza per giustapporre entrambe le facce.

Poiché la ricerca sui GAN e altri approcci all’apprendimento automatico è disponibile pubblicamente, la capacità di generare deepfakes si sta diffondendo. Il software open source consente già a chiunque abbia alcune conoscenze tecniche e una scheda grafica abbastanza potente di creare un deepfake.

Alcune istituzioni accademiche come la New York University stanno adottando approcci univoci per l’alfabetizzazione mediatica. Una classe dell’Interactive Telecommunications Program (ITP) alla NYU Tisch – “Faking the News” – espone agli studenti i pericoli dei deepfake insegnando loro come creare contenuti usando le tecniche di IA. “Lo studio di questa tecnologia ci aiuta non solo a comprendere le potenziali implicazioni ma anche i limiti“, ha affermato Chloe Marten, product manager di Dow Jones.

Tecniche utilizzate per creare deepfakes

I creatori di Deephake possono utilizzare una varietà di tecniche. Eccone alcune:

Faceswap: un algoritmo può inserire senza problemi il volto di una persona in un video di destinazione. Questa tecnica potrebbe essere utilizzata per posizionare il viso di una persona sul corpo di un attore e metterlo in situazioni in cui non era realmente presente.

Sincronizzazione labiale: I falsi possono innestare una bocca che sincronizza le labbra sul viso di qualcun altro. Combinare il filmato con un nuovo audio potrebbe far sembrare che stiano dicendo cose che non sono.

Rievocazione facciale: i falsari possono trasferire le espressioni facciali da una persona a un altro video. Con questa tecnica, i ricercatori possono giocare con l’aspetto di una persona e farli sembrare disgustati, arrabbiati o sorpresi.

Trasferimento di movimento: i ricercatori hanno anche scoperto come trasferire i movimenti del corpo di una persona in un video sorgente a una persona in un video di destinazione. Ad esempio, possono catturare i movimenti di un ballerino e far muovere gli attori bersaglio allo stesso modo. In collaborazione con i ricercatori dell’Università della California, Berkeley, il corrispondente del Journal Jason Bellini ha provato questa tecnica per se stesso e ha finito per ballare come Bruno Mars.

I giornalisti hanno un ruolo importante nell’informare il pubblico sui pericoli e le sfide della tecnologia di intelligenza artificiale. Segnalare questi temi è un modo per sensibilizzare e informare il pubblico.

Come rilevare i deepfakes

Stiamo lavorando a soluzioni e test di nuovi strumenti che possono aiutarci a rilevare o prevenire media falsi. In tutto il settore, le organizzazioni giornalistiche possono prendere in considerazione molteplici approcci per aiutare ad autenticare i media se sospettano alterazioni.

“Esistono modi tecnici per verificare se il metraggio è stato alterato, ad esempio esaminarlo fotogramma per fotogramma in un programma di editing video per cercare eventuali forme innaturali e elementi aggiunti o eseguire una ricerca inversa di immagini“, ha affermato Natalia V. Osipova , un giornalista video senior del Journal. Ma l’opzione migliore è spesso la segnalazione tradizionale: “Raggiungi direttamente la fonte e l’argomento, e usa il tuo giudizio editoriale“.

Esaminare la fonte

Se qualcuno ha inviato filmati sospetti, un buon primo passo è provare a contattare la fonte. Come l’ha ottenuta quella persona? Dove e quando è stato girato? Ottenere quante più informazioni possibili, chiedere ulteriori prove delle affermazioni e quindi verificarle è la chiave.

Se il video è online e l’autore del caricamento è sconosciuto, vale la pena esplorare altre domande: chi avrebbe presumibilmente girato il filmato? Chi l’ha pubblicato e condiviso, e con chi? Il controllo dei metadati del video o dell’immagine con strumenti come InVID o altri visualizzatori di metadati può fornire risposte.

Oltre a seguire internamente questo processo, collaboriamo con organizzazioni di verifica dei contenuti come Storyful e Associated Press. Questo è un panorama in rapida evoluzione con soluzioni emergenti che appaiono regolarmente sul mercato. Ad esempio, i nuovi strumenti, tra cui TruePic e Serelay, utilizzano la blockchain per autenticare le foto. Indipendentemente dalla tecnologia utilizzata, gli esseri umani nella redazione sono al centro del processo.

“La tecnologia da sola non risolverà il problema“, ha detto Rajiv Pant, chief technology officer presso il Journal. “Il modo per combattere i deepfakes è aumentare gli umani con strumenti di intelligenza artificiale“.

Trovare versioni precedenti del filmato

I Deepfake sono spesso basati su filmati che sono già disponibili online. I motori di ricerca inversa come Tineye o Google Image Search sono utili per trovare possibili versioni precedenti del video per scoprire se un suo aspetto è stato manipolato.

Esaminando il filmato

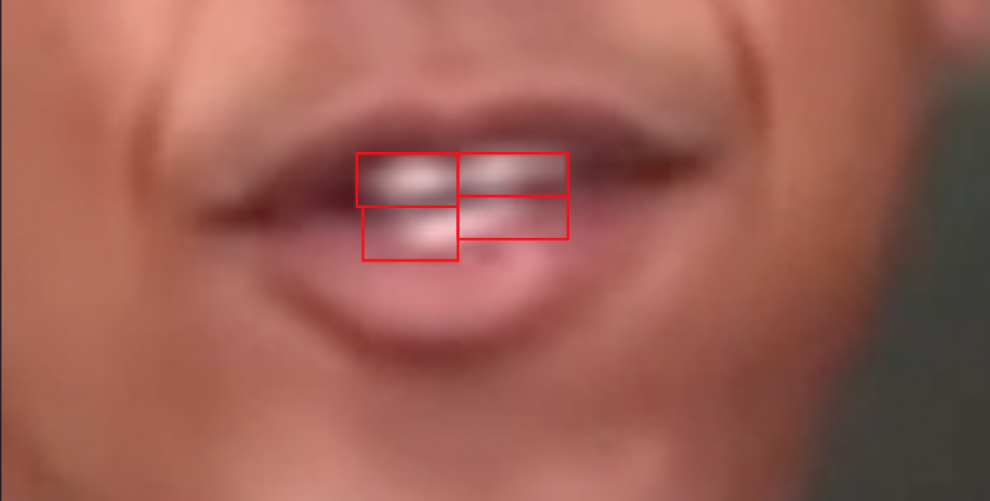

La modifica di programmi come Final Cut consente ai giornalisti di rallentare le riprese, ingrandire l’immagine e guardarla fotogramma per fotogramma o mettere in pausa più volte. Questo aiuta a rivelare problemi evidenti: scintillio e sfocatura intorno alla bocca o al viso, luci o movimenti innaturali, e le differenze tra i toni della pelle sono segni rivelatori di un deepfake.

Come esperimento, ecco alcuni inconvenienti che il team forense del Journal ha trovato durante una sessione di allenamento utilizzando filmati di Barack Obama creati dai produttori di video di BuzzFeed.

Le box-like shapes intorno ai denti rivelano che questa è una foto cucita sul filmato originale.

I movimenti innaturali come il mento mobile e il collo crescente mostrano che il filmato è falso

Oltre a questi dettagli facciali, potrebbero esserci anche piccole modifiche in primo piano o sullo sfondo del filmato. Sembra che un oggetto sia stato inserito o eliminato in una scena che potrebbe modificare il contesto del video (ad esempio un’arma, un simbolo, una persona, ecc.)? Ancora una volta, il bagliore, la sfocatura e la luce innaturale possono essere indicatori di filmati falsi.

Nel caso dell’audio, fai attenzione all’intonazione innaturale, alla respirazione irregolare, alle voci dal suono metallico e alle modifiche evidenti. Questi sono tutti suggerimenti che l’audio potrebbe essere stato generato dall’intelligenza artificiale. Tuttavia, è importante notare che artefatti dell’immagine, glitch e imperfezioni possono essere introdotti anche dalla compressione video. Ecco perché a volte è difficile determinare in modo definitivo se un video è stato creato o meno.

La democratizzazione della creazione del deepfake si aggiunge alla sfida

Un certo numero di aziende sta creando tecnologie – spesso per motivi innocui – che tuttavia potrebbero alla fine essere utilizzate per creare deepfakes. Qualche esempio:

Estrazione dell’oggetto

Adobe sta lavorando a Project Cloak, uno strumento sperimentale per la rimozione degli oggetti nei video, che rende facile per gli utenti portare fuori dal filmato persone o altri dettagli. Il prodotto potrebbe essere utile nell’editing di immagini in movimento. Ma alcuni esperti pensano che i micro-edits come questi – la rimozione di piccoli dettagli in un video – potrebbero essere persino più pericolosi di falsi sfacciati poiché sono più difficili da individuare.

Alterazione del tempo

Esistono degli algoritmi per la traduzione di immagini che consentono agli utenti di modificare il tempo o l’ora del giorno in un video, come questo esempio sviluppato dal produttore di chip Nvidia utilizzando reti generative contraddittorie. Questi algoritmi potrebbero essere utilizzati per la post-produzione di scene di film girate durante giorni con condizioni meteorologiche diverse. Ma questo potrebbe essere problematico per le redazioni e altri, perché al fine di verificare le riprese e restringere quando i video sono stati girati, è comune esaminare l’ora del giorno, il tempo, la posizione del sole e altri indicatori per individuare le incongruenze.

Sia Adobe che Nvidia non hanno voluto commentare.

Voci artificiali

I file audio possono anche essere manipolati automaticamente: una società, Lyrebird, crea voci artificiali basate su campioni audio di persone reali. Un minuto di registrazioni audio è sufficiente per generare un’intera replica digitale in grado di pronunciare qualsiasi frase che l’utente digita nel sistema. Le applicazioni di questa tecnologia includono la possibilità per gli sviluppatori di videogiochi di aggiungere voci ai personaggi.

Strumenti di consumo pronti all’uso che semplificano la manipolazione di video e audio possono accelerare la proliferazione di deepfakes. Alcune delle aziende dietro questi strumenti stanno già prendendo in considerazione misure di salvaguardia per prevenire l’uso improprio della loro tecnologia. “Stiamo esplorando diverse direzioni, tra cui tecniche di crittografia della crittografia, nuovi protocolli di comunicazione, nonché lo sviluppo di partnership con il mondo accademico per lavorare sulla sicurezza e l’autenticazione“, ha dichiarato Alexandre de Brébisson, CEO e cofondatore di Lyrebird.

Le ramificazioni di Deepfakes per la società

Sebbene queste tecniche possano essere utilizzate per ridurre significativamente i costi di produzione di film, giochi e intrattenimento, rappresentano un rischio per i media e per la società in generale. Ad esempio, video falsi potrebbero collocare i politici in riunioni con agenti stranieri o addirittura mostrare soldati che commettono crimini contro civili. Un falso audio potrebbe far sembrare che i funzionari governativi stiano pianificando privatamente attacchi contro altre nazioni.

“Sappiamo che i deepfakes e altre manipolazioni di immagini sono efficaci – questo tipo di falsificazione può avere ripercussioni immediate”, ha affermato Roy Azoulay, fondatore e CEO di Serelay, una piattaforma che consente agli editori di proteggere i loro contenuti dalle contraffazioni. “Il punto che dobbiamo veramente osservare è quando diventano economici, perché facilita la diffusione di unità economiche ed efficaci”.

I legislatori come i senatori Mark Warner e Marco Rubio stanno già lanciando l’allarme circa scenari come questi e stanno lavorando su possibili strategie per evitarli. Inoltre, i deepfakes potrebbero essere utilizzati per ingannare le organizzazioni di notizie e minare la loro affidabilità. Pubblicare un video falso non verificato in una notizia potrebbe macchiare la reputazione di una redazione e alla fine portare i cittadini a perdere la fiducia nelle istituzioni dei media. Un altro pericolo per i giornalisti: attacchi personali profondi che mostrano i professionisti delle notizie in situazioni compromettenti o che alterano i fatti – di nuovo volti a screditarli o a intimidirli.

Mentre i deepfakes si fanno strada nei social media, la loro diffusione probabilmente seguirà lo stesso schema di altre storie di notizie false. In uno studio del MIT che studia la diffusione di falsi contenuti su Twitter pubblicati tra il 2006 e il 2017, i ricercatori hanno scoperto che “la menzogna si diffondeva in modo sempre più lontano, più veloce, più profondo e più ampio della verità in tutte le categorie di informazioni“. Le false storie avevano il 70% in più di probabilità di essere ritwittate rispetto alla verità e hanno raggiunto 1.500 persone sei volte più velocemente rispetto articoli accurati.

Cosa ci aspetta?

I Deepfakes stanno crescendo velocemente. È certo che questi falsi elaborati renderanno più difficile la verifica dei media, e questa sfida potrebbe diventare più difficile col passare del tempo.

“Abbiamo visto questo rapido aumento della tecnologia di deep learning e la domanda è: continuerà o continuerà? Che cosa succederà dopo? “, Ha detto Hany Farid, un esperto di foto-forense, che si unirà alla facoltà di Berkeley dell’Università della California il prossimo anno. Ha detto che i prossimi 18 mesi saranno critici: “Penso che i problemi si stiano già verificando”, aggiungendo che si aspetta che i ricercatori abbiano fatto progressi prima delle elezioni del 2020.

Nonostante l’attuale incertezza, le redazioni possono e devono seguire l’evoluzione di questa minaccia conducendo ricerche, collaborando con istituzioni accademiche e formando i propri giornalisti su come sfruttare nuovi strumenti.

Ed ecco la soluzione al nostro quiz deepfake qui sopra: il filmato a sinistra è stato modificato con l’aiuto della AI.

Un team di ricercatori ha utilizzato una forma di rievocazione facciale chiamata “Deep Video Portraits” per trasferire i movimenti facciali di Barack Obama al volto di Ronald Reagan. Ecco come appare: