Por Oksana Poluliaj

Hoy en día, casi todo el mundo tiene acceso a herramientas de inteligencia artificial (IA) capaces de crear imágenes que parecen realistas, al menos a primera vista. Sin embargo, estas tecnologías se están convirtiendo en una poderosa herramienta en manos de quienes buscan manipular la opinión pública. Rusia utiliza activamente la IA en su guerra informativa. En este artículo se explica cómo funcionan las falsificaciones de IA, por qué son especialmente peligrosas en tiempos de guerra y cómo reconocerlas.

¿Podemos reconocer las imágenes generadas por IA?

Según un estudio de la Universidad de Chicago, sólo el 60% de los internautas es capaz de distinguir si una imagen ha sido creada por IA, lo que resulta preocupante dado el constante perfeccionamiento de este tipo de tecnologías. Los ucranianos no son una excepción. Según una encuesta de Kantar Ucrania (febrero de 2024), el 79 % de los encuestados sabe lo que es la IA, pero solo el 42 % confía en sus habilidades para reconocer este tipo de contenidos.

La incapacidad de distinguir entre lo real y lo generado tiene importantes consecuencias: desde la violación de los derechos de autor hasta los riesgos de desinformación y fraude.

¿Por qué pueden ser peligrosos los contenidos generados por IA?

Las imágenes de inteligencia artificial se utilizan a menudo para manipular las emociones. Probablemente hayas visto imágenes en tu Facebook de supuestos militares pidiéndote que les apoyes en ocasiones importantes, como su cumpleaños o su boda. ¿Qué te parece si le das a “me gusta” en un comentario a un soldado que se acaba de casar? ¿O tal vez deberías apoyar con un comentario a un joven al que nadie de su familia ha saludado en su cumpleaños?

Estas publicaciones reciben miles de “me gusta” y comentarios, lo que aumenta el alcance de las páginas. Sin embargo, su emotividad puede ocultar intenciones maliciosas: las páginas cambian de tema o se utilizan para difundir propaganda.

Las redes sociales ucranianas no son las únicas que se enfrentan al problema de la distribución de contenidos generados por IA. El Facebook estadounidense también está inundado de imágenes similares: de ancianos, amputados y bebés. Estas publicaciones suelen ir acompañadas de pies de foto emotivos como «Nadie me ha bendecido nunca» o «Lo he hecho yo mismo. Me encantaría recibir tus comentarios». En agosto de 2024, Renée DiResta, de la Universidad de Stanford, y Joshua Goldstein, del Centro de Seguridad y Tecnologías Emergentes de la Universidad de Georgetown, publicaron un estudio que demostraba que las imágenes generadas por IA son utilizadas activamente por estafadores y spammers. Tales imágenes contribuyen al rápido crecimiento de la audiencia de las páginas y aumentan el compromiso de los usuarios, lo que permite monetizar su popularidad. Como resultado, estas páginas cambian a menudo de nombre y empiezan a distribuir contenidos completamente diferentes, a veces de naturaleza fraudulenta.

Además de cambiar los títulos de las páginas, los estafadores también manipulan el contenido de los posts. Por ejemplo, ayer podías compartir una imagen de un soldado pidiendo oraciones por la victoria, y hoy descubres que ha sido sustituida por un post completamente distinto con el significado opuesto. Esta táctica engaña a los usuarios al crear la ilusión de un apoyo generalizado al nuevo post, aunque los likes y reposts hayan sido generados por otro contenido. StopFake investigó un caso similar: los atacantes editaron el contenido de una publicación, convirtiéndola en falsa, descrita en el siguiente artículo: Falso: Un piloto ucraniano secuestró un avión y “huyó a África con su amada”.

Analistas del Instituto de Información de Masas han descubierto que una organización religiosa con sede en China utiliza imágenes generadas por inteligencia artificial para atraer a ucranianos a sus filas. A los usuarios les gustan fotos emotivas de soldados ucranianos o ancianos, y se les invita a unirse a grupos cerrados de WhatsApp para rezar juntos. Sin embargo, en lugar de las oraciones prometidas por los soldados ucranianos, estas oraciones en línea difunden narrativas que toleran la glorificación del país agresor de Rusia. Los expertos del IMI subrayan que tales métodos se dirigen a personas vulnerables, en particular a aquellas cuyas familias tienen miembros militares. Estas personas suelen preocuparse por el curso de la guerra y buscan apoyo.

En tiempos de guerra, este tipo de acciones resultan especialmente amenazadoras. El Centro de Lucha contra la Desinformación del Consejo Nacional de Seguridad y Defensa señala que las páginas con imágenes generadas por IA atraen a un público numeroso que no es suficientemente crítico con la información en línea y es susceptible de ser manipulado. Esto da al enemigo una plataforma para promover narrativas peligrosas para Ucrania.

En octubre de 2024, Microsoft publicó un informe sobre ciberamenazas que abarcaba el periodo comprendido entre julio de 2023 y junio de 2024. Según el informe, países como Rusia, Irán y China utilizan cada vez más la IA para aumentar el alcance, la eficacia y la participación de sus campañas de información. Incluso los desarrolladores de herramientas de IA admiten que sus herramientas, como ChatGPT, están siendo utilizadas sin control por Rusia para manipular la opinión pública en todo el mundo.

Uno de los ejemplos más notables del ataque informativo de Rusia contra Ucrania fue el aluvión de imágenes de soldados ucranianos generadas por inteligencia artificial que circularon a finales de 2023. Estas imágenes iban acompañadas de textos en los que se afirmaba que los militares ucranianos de Avdiivka, en la región de Donetsk, rezaban por la salvación y pedían las oraciones de los ucranianos. Dada la complejidad de los combates en la región, estos mensajes tuvieron un fuerte impacto emocional.

Sin embargo, según las observaciones de StopFake, los principales difusores de estas publicaciones eran cuentas tipo bot. La escala y la velocidad de difusión del contenido indican que esta campaña fue una parte cuidadosamente planificada de la operación de desinformación de Rusia. Su principal objetivo era sembrar el miedo, el pánico y la incredulidad entre los ucranianos, así como minar la moral de los defensores.

Esta campaña también demuestra cómo se utilizan eficazmente las tecnologías de IA para crear la ilusión de apoyo o pánico a gran escala. Algunas de las imágenes de los militares en momentos de desesperación parecían tan realistas que podían confundir incluso a internautas experimentados. Además de minar la moral, estas manipulaciones pretenden reforzar las contradicciones internas de la sociedad, sembrar dudas sobre la estrategia de defensa de Ucrania y crear la imagen de un ejército “cansado”.

Esta foto muestra a un niño pequeño que supuestamente sobrevivió a otro bombardeo ruso de Dnipró. El pie de foto subraya emotivamente la tragedia: “Siempre recordará quién destruyó su mundo”. El niño está de pie sobre el telón de fondo de un edificio destruido, probablemente sosteniendo un trozo de pan. El galón y la bandera de su chaqueta indican claramente que es ucraniano. A pesar de los claros indicios de que la imagen era falsa, muchos usuarios se solidarizaron sinceramente con el niño en los comentarios, preguntando por la suerte de sus padres.

Esta imagen se hizo viral el 14 de enero de 2023, poco después de un ataque con misiles contra un rascacielos en Dnipró que mató a 46 personas, entre ellas seis niños, y dejó unos 80 heridos. Incluso las cuentas oficiales de la Verjovna Rada de Ucrania compartieron este contenido, lo que provocó un aluvión de indignación y críticas, ya que el uso de imágenes generadas por IA en un contexto así no hace sino socavar la credibilidad de los hechos reales.

Estas imágenes de IA, que simulan las consecuencias de la destrucción en Ucrania y el sufrimiento de la población civil, suelen hacerse virales. Se comparten incluso más activamente que las fotografías reales de las consecuencias de los ataques rusos. Algunos lo justifican diciendo que tales imágenes son sólo “ilustrativas”, pero las estadísticas demuestran lo contrario: El 40% de los usuarios no puede reconocer las imágenes generadas por IA.

El uso de este tipo de fotos no sólo desdibuja la realidad, sino que también distorsiona la verdad sobre los crímenes de guerra de Rusia. La propaganda rusa utiliza la saturación del espacio informativo con este tipo de materiales para formar una narrativa según la cual las víctimas civiles en Ucrania son invención de los servicios de inteligencia ucranianos u occidentales. La lógica de la propaganda es simple: “Si los ucranianos mienten sobre el niño de Dnipro, pueden mentir sobre otras tragedias”.

No obstante, puede consultar cómo la desinformación rusa crea y difunde este tipo de dudas en los artículos de StopFake: Falso: Vídeos y fotos de la masacre de los civiles de la región de Kyiv son una puesta en escena, Falso: Atrocidades de los militares rusos en Gostomel son una “puesta en escena” hecha por los ucranianos.

Estos casos subrayan la necesidad del pensamiento crítico y la verificación de la información, ya que la difusión descuidada de contenidos generados por IA hace inadvertidamente el juego a la propaganda rusa.

¿Cómo reconocer una imagen generada por IA?

Detectar imágenes falsas creadas por inteligencia artificial es difícil, pero no imposible. A continuación se presentan los principales enfoques y criterios para ayudar a determinar si una foto es real o generada por IA.

- Comprobación de marcas de agua y metadatos

- Marcas de agua. En primer lugar, comprueba si la imagen contiene una marca de agua de un generador de IA (por ejemplo, MidJourney o DALL-E). La marca de agua suele estar situada en la esquina de la imagen.

- Descripción de la imagen. Fíjate bien en los pies de foto o en los comentarios: el autor puede indicar la fuente original o señalar que la imagen se ha creado con ayuda de IA.

- Metadatos. Si están disponibles, el análisis de metadatos puede proporcionar información sobre la fecha de creación, la ubicación, los ajustes de la cámara e incluso la herramienta utilizada para crear la imagen. El análisis de metadatos puede ser una herramienta clave para autenticar imágenes. Para ello se pueden utilizar programas como ExifTool o Exif Pilot, que deben instalarse en un ordenador. Estos programas proporcionan un análisis detallado de los metadatos de los archivos y son adecuados para trabajar con diferentes formatos.

Una cómoda herramienta en línea es metadata2go, un servicio que permite comprobar rápidamente los metadatos subiendo un archivo a un sitio web.

2. Análisis visual de la imagen

Las fotos generadas por IA suelen tener distorsiones o detalles poco naturales. Entre las principales características:

- Fondo. Las imágenes suelen tener fondos borrosos o difuminados. Los objetos situados detrás del sujeto principal pueden estar distorsionados: alargados, colocados de forma poco natural o compuestos de varias partes.

- Iluminación. Las anomalías en la distribución de la luz son sombras irregulares, brillos extraños o iluminaciones que contradicen la ley de la física. Por ejemplo, los rayos del sol pueden “olvidarse” de la iluminación realista de un objeto.

- Detalles faciales y de las extremidades. Aunque la IA reproduce los rostros casi a la perfección, siguen produciéndose errores:

- Asimetría de la cara (tamaño desigual de los ojos, posición antinatural de los dientes o las orejas).

- Dedos de más, extremidades curvadas de forma poco natural o problemas en las uñas.

- Pequeños detalles e inscripciones. Los uniformes, el camuflaje o los galones de las imágenes suelen estar creados con errores: pueden ser ficticios o contener elementos poco realistas (por ejemplo, bolsas cosidas directamente a la túnica). Las inscripciones en las imágenes suelen consistir en letras aleatorias, lagunas o tener un aspecto ridículo.

- Duplicación y repetición de elementos. La IA suele representar a personas con rostros casi idénticos o duplicar texturas. Por ejemplo, las paredes, los muebles u otros objetos del fondo pueden estar repetidos.

- Colocación en el espacio. Fíjate en cómo se colocan los detalles entre sí. Los objetos, como gafas o joyas, pueden «fundirse» con el rostro o, por el contrario, estar a una distancia en la que no deberían estar.

- Artefactos digitales. Busca pixelación, anomalías extrañas de color o desenfoque en zonas donde no parece lógico.

3. Utilización de herramientas especializadas

Existen detectores de inteligencia artificial que permiten comprobar si se han generado con IA las imágenes. A continuación le presentamos cada una de las herramientas más populares:

Esta herramienta está especializada en el análisis de imágenes y vídeos para identificar posibles manipulaciones o generación de IA. Se pueden subir imágenes a la página web sin necesidad de registrarse y obtener un resultado rápido. La herramienta es conveniente para los usuarios que necesitan una solución sencilla y asequible.

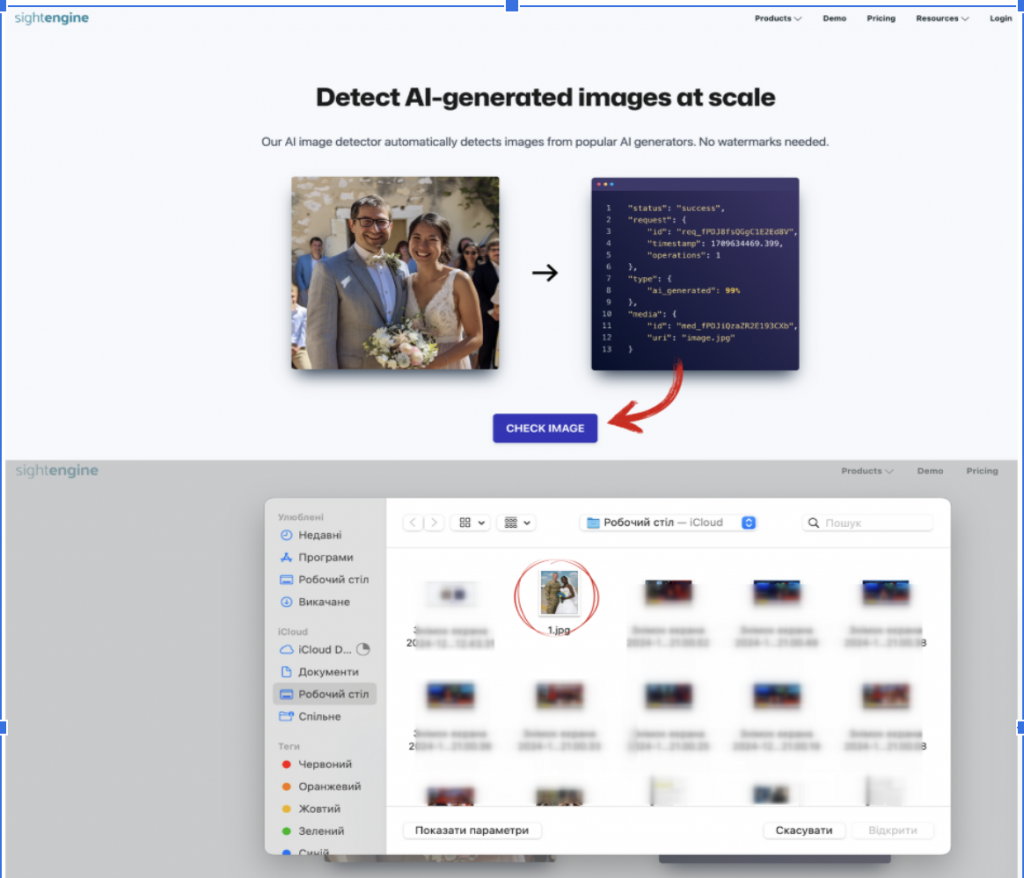

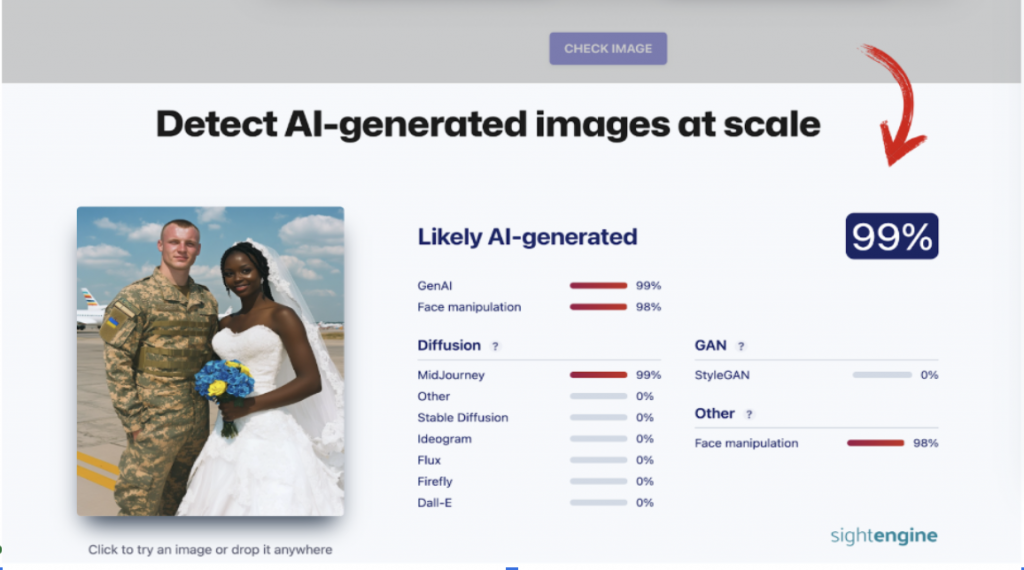

SightEngine es una potente herramienta que ofrece una amplia gama de funciones, entre ellas identificar imágenes generadas por IA, comprobar si el contenido cumple las normas y detectar manipulaciones.

El servicio está disponible en modo gratuito con funciones limitadas. Puede comprobar imágenes de forma gratuita y sin registrarse: sólo tiene que ir a la sección «Detect AI-generated images at scale», subir la imagen al sitio web y esperar los resultados. SightEngine es capaz de determinar la probabilidad de que la imagen haya sido creada por IA e indicar un generador específico (por ejemplo, MidJourney, DALL-E o Stable Diffusion).

Esta herramienta funciona como un servicio online y permite determinar rápidamente si una imagen ha sido creada por inteligencia artificial. Para un análisis básico, basta con utilizar la versión de prueba gratuita, pero es necesario registrarse en la página web. Una vez registrado, puede cargar una imagen y el sistema le proporcionará los resultados de la comprobación, indicando la probabilidad de generación por IA. La versión gratuita permite comprobar hasta 10 imágenes.

La herramienta es ideal para la verificación rápida de imágenes, pero no puede utilizarse sin registrarse.

Hive Moderation es una herramienta basada en API adecuada para comprobar automáticamente grandes volúmenes de imágenes. Al mismo tiempo, el servicio ofrece una versión de demostración gratuita para usuarios particulares. Para utilizarla, es necesario registrarse en el sitio web.

Sin embargo, puede comprobar imágenes sin registrarse. Para ello, debe ir a la sección de detección de«AI-generated content detection» y seleccionar la función«See our AI-Generated Content Detection tools in action». Puede cargar la imagen y obtener los resultados básicos de la comprobación, incluida información sobre el posible uso de generadores de IA.

Cada una de estas herramientas puede ser útil en función de sus necesidades: desde el análisis rápido de imágenes individuales hasta la verificación de contenidos a gran escala.

Importante: Estas herramientas no siempre proporcionan resultados precisos, especialmente si la imagen es de mala calidad, por lo que deben utilizarse como un método adicional de verificación, no como el principal. También recomendamos combinar el análisis con otros métodos de verificación para lograr la máxima confianza.

4. Aprendizaje interactivo

Para mejorar tus habilidades de reconocimiento de imágenes con IA, puedes utilizar plataformas interactivas, como el test de The New York Times. Te permiten entrenar tu capacidad de atención y mejorar tu habilidad para identificar falsificaciones.

La inteligencia artificial abre grandes oportunidades, pero al mismo tiempo crea riesgos para el espacio de la información, especialmente en tiempos de guerra.

Las imágenes generadas por IA pueden evocar emociones fuertes, inducir a error y servir de herramienta para las campañas de desinformación del enemigo.

Es importante recordar que cualquier interacción con contenidos sospechosos -un like, un comentario o un repost- puede jugar a favor del enemigo: puede promover narrativas propagandísticas, socavar la confianza en los hechos reales e incluso aumentar el pánico en la sociedad. Interactuar con la información en tiempos de guerra exige responsabilidad. La comprobación de los hechos y una actitud consciente ante los contenidos no sólo ayudarán a protegerse a uno mismo, sino que también contribuirán a la resistencia de la sociedad ante las amenazas de la información.

Este artículo ha sido elaborado con el apoyo del NDI